https://ollama.com/library/cogito

cogito

Cogito v1 Preview is a family of hybrid reasoning models by Deep Cogito that outperform the best available open models of the same size, including counterparts from LLaMA, DeepSeek, and Qwen across most standard benchmarks.

ollama.com

DEEP COGITO에서 cogito라는 하이브리드 추론 모델을 냈습니다.

70B 모델은 Llama4 Scout 모델보다 성능이 좋다 합니다.

Ollama에 있어서 사용이 매우 간편합니다.

사용 GPU: H100 80GB

cogito-70B는 llama3.3-70B 모델과 비슷한 45GB 필요했습니다.

이전 QWQ vs Llama3.3에서 했던 같은 코드에 모델만 변경해서 테스트했습니다.

QWQ vs Llama3.3 Ollama 기반 Agentic RAG 해보기

Agentic RAG를 두 가지의 llm으로 테스트해 봤습니다. 추론 오픈 모델 중 성능 높다고 알려진 QWQ-32B와 비추론 모델인 Llama3.3-70B입니다. 이미 Llama4도 나오긴 했으나, H100 한대로는 아직 어려워서 해

bigc.tistory.com

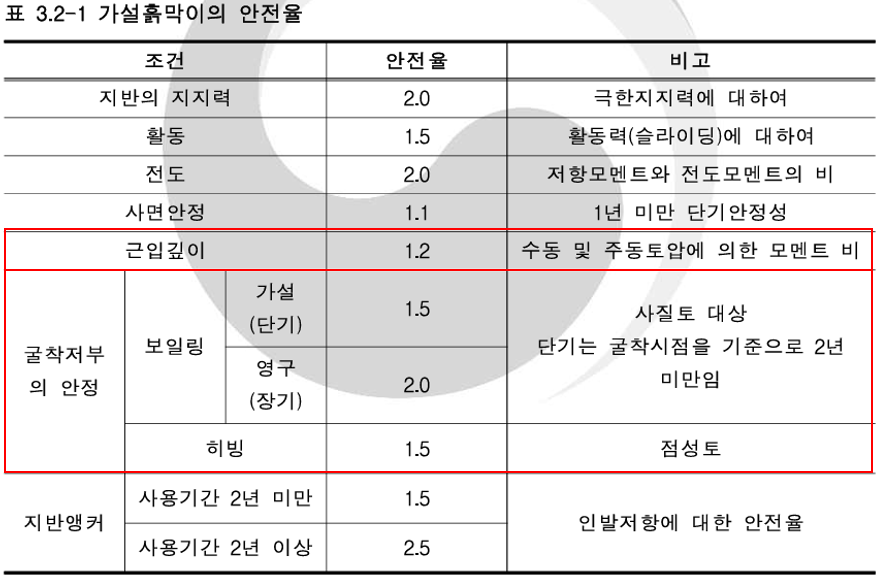

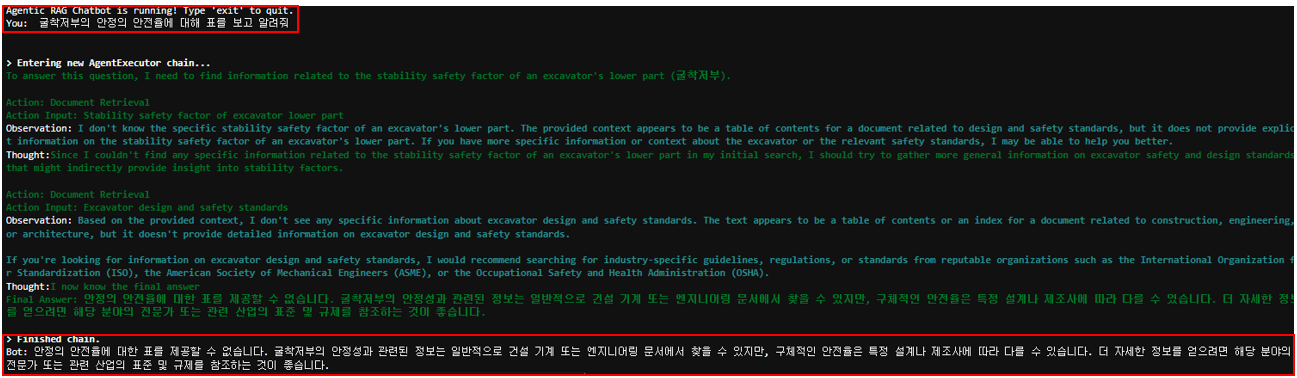

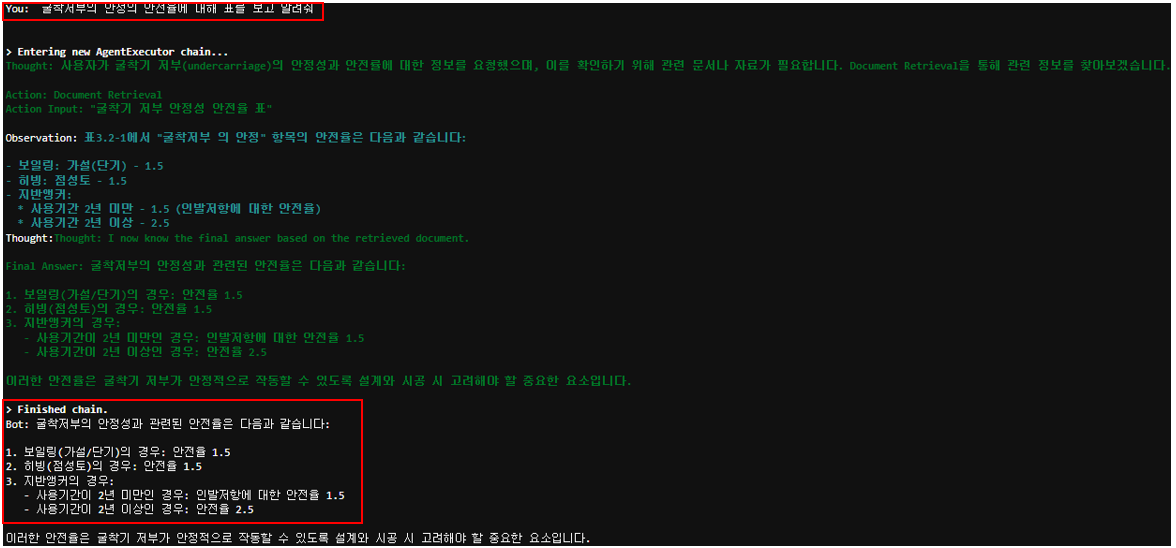

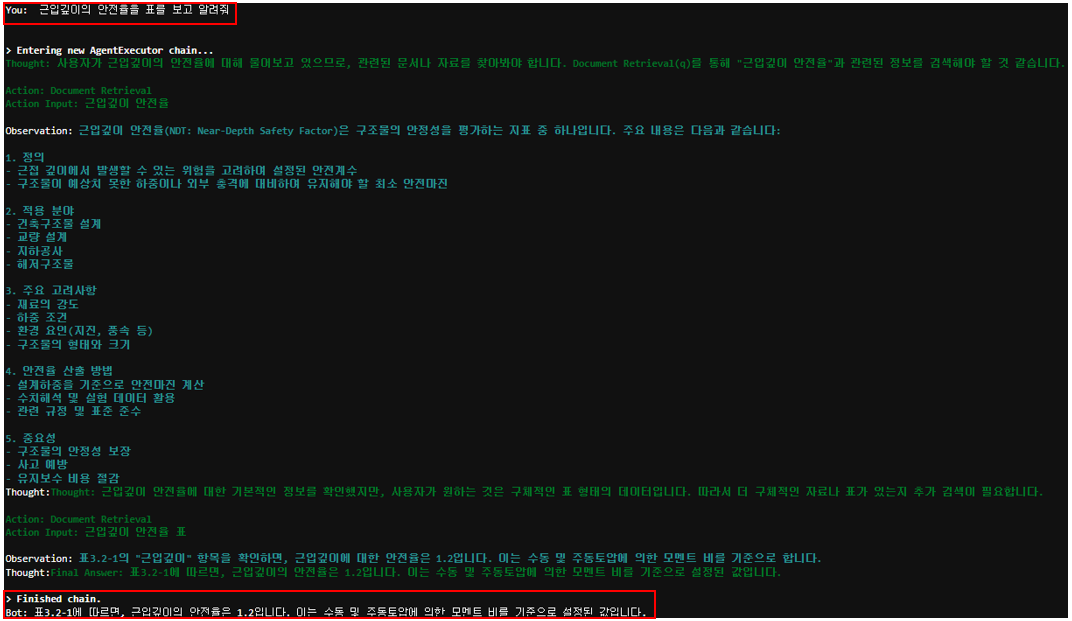

위 표가 markdown 형식으로 저장되어있는 벡터 DB 기반 질문을 던져서 llama3.3 모델과 비교해 봤습니다.

- llama3.3 기반 질문답: 표를 찾지 못함

- cogito-70B 기반 질문답: 이중표에 대한 완벽하진 않지만 표를 찾아서 답을 냄

- cogito-70B 기반 질문답: 표에 대한 답을 냄(llama3.3은 표를 찾지 못함)

일반 텍스트 기반 답은 llama3.3, cogito 모두 답을 잘 해내서 따루 첨부하지 않았습니다.

표와 텍스트 전체적으로 보면 cogito 모델이 llama3.3, qwq 보다 성능이 좋은 것 같습니다.

'AI > LLM' 카테고리의 다른 글

| Nanonets-OCR-s 사용 한국어 pdf OCR 해보기 (4) | 2025.06.18 |

|---|---|

| Unstructured PDF (multi-modal-rag) 사용 해보기 (0) | 2025.04.30 |

| 임베딩 모델 한국어 성능 비교(BGE-M3 vs E5-large) (0) | 2025.04.10 |

| QWQ vs Llama3.3 Ollama 기반 Agentic RAG 해보기 (0) | 2025.04.09 |

| PyMuPDF4LLM vs PyMuPDFLoader(PDF loader 비교) (0) | 2025.04.04 |